분류 모델의 성능을 평가할 때, 단순한 정확도(Accuracy)만으로는 부족합니다.

특히 불균형 데이터(정상 vs 이상, 스팸 vs 일반) 같은 현실 데이터를 다룰 땐

다양한 지표를 활용한 입체적 평가가 필요하죠.

이번 글에서는 실전에서 유용하게 쓰이는 특이도(Specificity), ROC & AUC, G-mean을 집중적으로 살펴봅니다.

특이도 (Specificity)

🔹 정의

실제 음성(Negative) 중에서, 모델이 음성으로 올바르게 예측한 비율

Specificity=TN / TN+FP

- TN: 진짜 정상인데 정상으로 맞춘 수

- FP: 정상인데 이상으로 잘못 판단한 수 (False Alarm)

🔹 해석

- 특이도가 높다 → 모델이 정상 데이터를 잘 걸러내고 있음

- 의료 진단, 보안 시스템 등에서 중요 (정상인데 오진하면 불필요한 조치가 많아짐)

특이도 vs 재현율 비교

ROC Curve & AUC

ROC란?

ROC (Receiver Operating Characteristic) Curve는

**분류 모델의 전체 민감도(재현율) vs 위양성률(1 - 특이도)**를 시각화한 그래프입니다.

- x축: 1 - 특이도 (False Positive Rate)

- y축: 재현율 (True Positive Rate)

AUC란?

ROC Curve 아래 면적(Area Under Curve)

이 값이 1에 가까울수록 모델의 분류 성능이 좋다고 판단합니다.

실전 활용

- 다양한 **임계값(threshold)**에 따른 분류 성능 변화를 확인 가능

- 모델의 전반적인 성능을 요약할 때 유용

- 이진 분류 모델 평가 시 거의 항상 포함되는 지표

G-mean (Geometric Mean)

🔹 정의

정밀도보다는 재현율과 특이도의 "균형"에 초점을 둔 지표

G-mean=루트(Recall×Specificity)

🔹 왜 필요한가?

- 불균형 데이터에서,

단순 정확도는 대부분의 정상 클래스만 잘 맞춰도 높게 나올 수 있음 - G-mean은 정상도 + 이상 탐지 성능을 동시에 고려해서

전체적인 분류의 균형 잡힌 성능을 평가함

🔹 예시

→ 모델 B는 양쪽 성능이 균형 잡혀 있으므로 G-mean이 더 높고,

→ 실제 운영에서는 B가 더 적절한 모델일 수 있음

언제 어떤 지표를 봐야 할까?

마무리 요약

정리하면

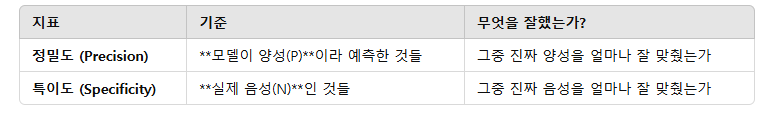

정밀도(Precision)는 "모델이 양성이라 한 것 중 얼마나 맞췄나",

특이도(Specificity)는 **"실제 음성 중 얼마나 잘 걸러냈나"**입니다.

둘 다 분류 모델에서 매우 중요한 역할을 하며, 불균형 데이터에서는 반드시 함께 고려되어야 해요!

'머신러닝 분석 > 회귀 분석' 카테고리의 다른 글

| 회귀분석 심화: 교호작용과 명목형 변수 처리 (1) | 2025.03.26 |

|---|---|

| 변수 선택법 (0) | 2025.03.26 |

| 모델 성능지표 한눈에 정리 – 예측력부터 분류 성능까지 (0) | 2025.03.25 |

| 왜 SSR은 예측값에서 평균을 빼서 계산할까? (0) | 2025.03.25 |

| 회귀 모델의 성능지표 (0) | 2025.03.25 |